根据4月9日发表在《Scientific Reports》上的一项研究,在将PET/CT图像上的肿瘤分类为良性或恶性时,视觉转换(ViT)AI模型的性能优于卷积神经网络(CNN)模型。

在一项正面比较中,日本大阪大学的研究人员证明,在对PET/CT成像结果进行分类时,ViT模型的性能优于CNN模型。该小组指出,这一结果提高了该方法的临床价值。

研究主要作者Daiki Nishigaki医学博士及其同事写道:“我们希望ViT模型将帮助用户区分PET/CT图像中的良性和恶性切片,并避免忽视FDG摄取不明显的病变。”

ViT模型基于最初主要用于自然语言处理任务的架构,后经过调整,包括将图像处理为标记序列的机制。ViTs的一个优点是,它们可以整合整个图像中的信息,而CNN则获得更多的本地化特征。

他们补充道,很少有研究对这些方法进行比较。因此,研究人员将这两种方法置于一项艰巨的临床任务中:将F-18 FDG-PET/CT切片区分为良性或恶性,尤其是在F-18 FDG放射性示踪剂摄取不良的病变中。

作者指出:“在日常医疗实践中,由于生理FDG摄取或FDG摄取不良的癌症,通常很难做出临床决策。”

这项研究包括 2020 年 1 月至 2021 年 8 月期间在大阪大学医院接受全身 PET/CT 扫描的 143 名活动性腹盆腔癌患者和 64 名没有任何活动性癌症的患者的影像学检查。

利用这些数据,研究人员对先前开发的ViT-B/16模型进行了训练,无需修改即可将PET/CT图像分类为“阳性”或“阴性“(恶性或良性)。接下来,他们将ViT的性能与两个基线CNN模型(称为DenseNet和EfficientNet)在4852张PET/CT图像上进行了测试比较。

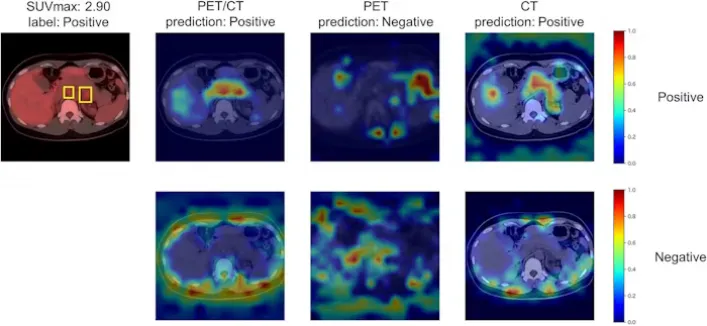

图示为基于 ViT 的模型对“阳性”类样本 PET/CT、PET 和 CT 测试图像的预测和 Grad-CAM。使用每种模态的训练数据对ViT进行了微调。图中所示的边界框表示恶性病变。Grad-CAM的顶行显示“阳性”预测的重要区域,底行显示“阴性”预测的区域。图片由Scientific Reports提供。

根据研究结果,ViT模型的受试者工作特征曲线下面积(AUC)为90%,优于EfficientNet(87%)和DenseNet(87%)模型。.

此外,作者补充道,即使图像中的F-18 FDG放射性示踪剂摄取率较低,ViT模型的AUC也达到了81%,与DenseNet模型(65%)相比更高。

研究人员指出,最终,这项研究的价值在于,它证明了ViT对PET / CT图像中F-18 FDG摄取进行分类的有用性,将这项研究扩展到其他机构是未来的一项重要任务。

研究人员写道:“我们通过展示ViT对容易遗漏的肿瘤疾病病例的敏感分析,证明了它的临床价值。”